Eksperci wzywają do wstrzymania dalszego rozwoju sztucznej inteligencji. Co ich do tego skłania?

Sztuczna inteligencja przeżywa ostatnio ogromny boom. Wszyscy są tak podekscytowani tą technologią, że nawet nie zdają sobie sprawy z zagrożeń, które mogą pojawić się w przyszłości. Eksperci AI biją obecnie na alarm, ostrzegając, że firmy powinny zacząć zajmować się ryzykiem, zanim będzie za późno.

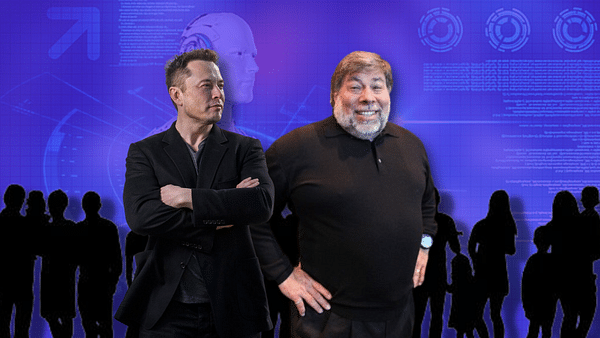

W najnowszym liście otwartym zatytułowanym "Pause Giant AI Experiments: An Open Letter", eksperci od sztucznej inteligencji (AI) wzywają firmy pracujące w tej dziedzinie do tymczasowego wstrzymania rozwoju generatywnych systemów AI. List, podpisany przez ponad 1000 osób, w tym Elona Muska, Steve'a Wozniaka, Evana Sharpa, Craiga Petersa i Yoshua Bengio, podkreśla niepewność co do potencjalnego przyszłego wpływu rezultatów tych prac.

W liście eksperci sugerują sześciomiesięczną pauzę w celu opracowania polityki regulacyjnej i procedur, które pozwolą na bezpieczny postęp technologii AI. Pauza powinna dotyczyć tylko szkolenia systemów AI potężniejszych niż GPT-4, generatywny model AI opracowany przez OpenAI. Jeśli apel ekspertów nie zostanie wysłuchany, list sugeruje, aby rządy nałożyły moratorium.

Firmy inwestujące w rozwój generatywnej AI i powiązanych technologii obejmują gigantów takich jak Microsoft $MSFT, Alphabet $GOOGL, Alibaba $BABA i Baidu $BIDU. List ekspertów wzywa do wprowadzenia protokołów bezpieczeństwa i zapewnienia pozytywnego wpływu i możliwości zarządzania ryzykiem. Wynik listu może spowodować, że firmy albo zatrzymają się i sformułują nowe polityki, albo przynajmniej zastanowią się nad potencjalnym wpływem i podejmą niezbędne działania.

GPT-4 jako czynnik wyzwalający potencjalne problemy

Wprowadzony niedawno GPT-4 zaimponował użytkownikom swoimi możliwościami w prowadzeniu rozmów, pisaniu piosenek i streszczaniu długich dokumentów. Reakcja na ten model sprawiła, że konkurenci tacy jak Alphabet Inc przyspieszyli prace nad podobnymi dużymi modelami językowymi. Jednak eksperci od AI wzywają do spowolnienia rozwoju, dopóki nie zrozumiemy lepiej konsekwencji i potencjalnych szkód dla społeczeństwa.

The Future of Life Institute, organizacja non-profit finansowana głównie przez Musk Foundation, londyńską grupę Founders Pledge oraz Silicon Valley Community Foundation, która wystosowała list otwarty, uważa, że potężne systemy AI powinny być rozwijane tylko wtedy, gdy jesteśmy pewni, że ich skutki będą pozytywne, a ryzyko możliwe do opanowania. Organizacja wzywa również do utworzenia organu regulacyjnego, który zapewniłby, że rozwój AI służy interesowi publicznemu.

Elon Musk, współzałożyciel OpenAI i jeden z ekspertów podpisanych pod listem, znany jest ze swoich ostrzeżeń przed potencjalnym ryzykiem związanym z rozwojem AI. Mówi, że niezbędne jest ustanowienie wspólnych protokołów bezpieczeństwa opracowanych przez niezależnych ekspertów i wzywa deweloperów do współpracy z decydentami w zakresie zarządzania.

Dyrektor wykonawczy OpenAI, Sam Altman, oraz prezesi Alphabet i Microsoft, Sundar Pichai i Satya Nadella, nie znaleźli się wśród sygnatariuszy listu otwartego. Mimo to, list stanowi ważny krok w kierunku otwarcia dyskusji na temat przyszłości AI i potencjalnych zagrożeń, jakie ze sobą niesie.

Możliwe implikacje listu

Istnieje kilka możliwych implikacji, które mogą wynikać z listu. Jedną z nich jest to, że firmy i instytucje badawcze zaangażowane w rozwój AI mogłyby tymczasowo wstrzymać swoją działalność i przemyśleć swoje praktyki. Taki scenariusz pozwoliłby ekspertom i regulatorom przyjrzeć się dotychczasowemu rozwojowi i podjąć niezbędne środki w celu zapewnienia bezpieczeństwa i zrównoważonego rozwoju w dziedzinie AI.

Alternatywnie, list mógłby doprowadzić do zwiększenia świadomości potencjalnych zagrożeń związanych z rozwojem AI oraz potrzeby ustanowienia protokołów bezpieczeństwa i procedur regulacyjnych. Dzięki temu firmy mogłyby bardziej skupić się na tworzeniu bezpieczniejszych i bardziej etycznych systemów AI, które mają pozytywny wpływ na społeczeństwo.

Wreszcie, list mógłby zainspirować rządy i organizacje międzynarodowe do rozważenia wprowadzenia środków regulacyjnych i moratoriów na rozwój AI. Zapewniłoby to, że rozwój AI jest prowadzony zgodnie z najlepszym interesem społeczeństwa i zarządzany w celu zminimalizowania potencjalnych negatywnych skutków.

Niezależnie od wyniku listu otwartego, jasne jest, że debata na temat bezpieczeństwa i etyki rozwoju AI jest coraz bardziej pilna. Ponieważ systemy AI, takie jak GPT-4, stają się coraz bardziej wszechobecne w codziennym życiu, istnieje potrzeba skupienia się na tym, jak te technologie mogą być wykorzystywane dla dobra społeczeństwa bez narażania prywatności, bezpieczeństwa lub interesów jednostek.

Jednym z przykładów pokazujących, jak systemy AI mogą być wykorzystywane dla dobra publicznego, jest zastosowanie GPT-4 do rozwiązywania problemów środowiskowych, zdrowotnych lub gospodarczych. Z drugiej strony należy rozważyć możliwe zagrożenia, takie jak niewłaściwe wykorzystanie technologii do szerzenia dezinformacji, manipulowania opinią publiczną czy zwiększania nierówności w dostępie do technologii.

List otwarty "Pause Giant AI Experiments" jest wezwaniem do refleksji nad drogą, jaką obierze rozwój AI. To, czy uda się osiągnąć konsensus między ekspertami, firmami i rządami, pozostaje pytaniem. Ważne jest jednak, aby naukowcy, liderzy branży i decydenci skupili się na wspólnej pracy, aby znaleźć sposoby zabezpieczenia i uregulowania rozwoju AI, które będą w najlepszym interesie ludzkości.

OSTRZEŻENIE: Nie jestem doradcą finansowym, a niniejszy materiał nie służy jako rekomendacja finansowa lub inwestycyjna. Treść tego materiału ma charakter czysto informacyjny.